G DATA / Cybersicherheit in Zahlen 2023

Und jetzt?

Langfristig bietet künstliche Intelligenz viele Chancen für eine bessere Zukunft. Kurzfristig wird sie jedoch zum Problem für die Sicherheit elektronischer Systeme. Wie lösen wir es? Und wie kommen wir bis dahin klar?

Die Zukunft hat begonnen. Sie heißt künstliche Intelligenz (KI) und sorgt seit Monaten für optimistische, bizarre, beunruhigende, erstaunliche und vor allem spektakuläre Nachrichten. Die vielen neuen Möglichkeiten der Technologie sind noch lange nicht absehbar. Klar ist nur: Sie wird etliche gesellschaftliche Grundlagen verändern – wie wir arbeiten, lernen, uns organisieren, wie wir leben. Diese Veränderungen erleben wir schon sehr bald, zuallererst in der Wirtschaft, wo sich KI schon seit einiger Zeit rasend schnell verbreitet. Unternehmen nutzen selbstlernende Systeme in der Produktion, Verwaltung, Logistik, zur Planung, als persönliche Assistenz. Ein Ende der Entwicklung ist nicht vorhersehbar. Denn es gilt dieselbe Regel wie bei jeder erfolgreichen neuen Technologie: Ist sie endlich alltagsreif, investieren alle gleichzeitig und beschleunigen damit ihre Entwicklung enorm.

Was wie eine plötzliche Explosion der Möglichkeiten aussieht, ist tatsächlich das Ergebnis eines langen Prozesses. Schon 1950 entwickelte der britische Mathematiker Alan Turing in seinem Artikel „Computing Machinery and Intelligence“ die Idee eines universalen, intelligenten Computers. Nur sechs Jahre später wurde auf der Dartmouth-Konferenz, die von den damals wichtigsten IT-Pionieren organisiert worden war, das Forschungsgebiet KI definiert. Heute gelten neuronale Netze und Selbstverbesserung als revolutionär, tatsächlich standen sie schon damals auf dem Programm.

Die Technologie blieb jedoch lange weit hinter der Theorie zurück. Insbesondere Künstliche Neuronale Netzwerke (KNN), die von biologischen neuronalen Netzen wie dem Gehirn inspiriert sind, schienen lange nicht praktikabel. Erst in den Achtzigerjahren wurde die Grundlage für die gewaltigen Fortschritte seit etwa 2010 geschaffen, die schließlich zum sogenannten Deep Learning führten: Maschinen lernen jenseits algorithmischer, regelbasierter Systeme selbstständig und können sich weiterentwickeln, was zu großen Durchbrüchen bei der maschinellen Übersetzung sowie bei Bild und Spracherkennung geführt hat. Parallel entwickelte sich die generative KI, die auf der Basis von Wahrscheinlichkeiten selbstständig Bilder (Midjourney) oder Texte (ChatGPT) produziert.

Die Angst vor der neuen Intelligenz

Beide Modelle vervielfachten die Möglichkeiten künstlicher Intelligenz enorm, aber auch die Angst vor ihr. Viele Menschen sorgen sich wegen möglicher ökonomischer Probleme, etwa davor, ihren Arbeitsplatz zu verlieren. Andere haben Angst vor massenhaften Manipulationen per Deepfake. Einige fürchten gar eine „KI-Apokalypse“.

Nick Bostrom, Philosoph und Gründer des Future of Humanity Institute an der University of Oxford, hat das Konzept des „existenziellen Risikos“ von KI entwickelt: Ihr Tun könnte unbeabsichtigte Konsequenzen haben und die Menschheit bedrohen. Anfang 2023 thematisierte ein offener Brief in den USA diese Endzeittheorie. „Sollen wir es hinnehmen, dass ,nichtmenschliche Intelligenzen‘ entstehen, die uns irgendwann überflüssig machen und ersetzen könnten?“, hieß es in dem Schreiben, das unter anderen vom Hightech-Milliardär Elon Musk und Apple-Mitbegründer Steve Wozniak unterzeichnet wurde. Sie forderten, die Entwicklung von KI für eine kurze Zeit auszusetzen, um klare Regeln für den Umgang mit der Technologie zu erarbeiten.

Nach klaren Regeln fragen auch große Tech-Unternehmen und die Vorreiter in Sachen künstlicher Intelligenz: OpenAI, IBM, Microsoft, Google. Sam Altman, CEO von OpenAI, und der renommierte KI-Forscher Gary Marcus schlugen dem US-Kongress in einer Anhörung gar vor, eine Art internationale Behörde für künstliche Intelligenz – vergleichbar mit der International Atomic Energy Agency (IAEA) für Atomenergie oder dem CERN für Hochenergiephysik – zu gründen.

Die Frage ist also längst nicht mehr ob, sondern wie reguliert wird. Die USA setzten bislang auf eigene Maßnahmen der Entwickler und eher allgemeine Regeln wie den California Consumer Privacy Act und dessen Erweiterung, den California Privacy Rights Act („CPRA“), der die Daten der Verbraucherinnen und Verbraucher schützen soll, auch vor KI. Inzwischen will auch die US-Regierung konkretere Gesetze erarbeiten – und dabei mit der Europäischen Union zusammenarbeiten.

Die EU ist nämlich einen Schritt weiter und hat einen Gesetzesentwurf vorgelegt, den EU AI Act. Kern der Vorlage ist eine Risikobewertung, auf deren Grundlage KI-Anwendungen erlaubt (minimales bis großes Risiko) oder verboten (unannehmbares Risiko) werden sollen. Eine Bedingung für alle Anwendungen: Transparenz. Den Nutzerinnen und Nutzern muss bewusst gemacht werden, dass sie eine KI nutzen.

Künstliche Intelligenz ist eine Technologie mit Schwäche. Doch im Moment ist es wie bei jeder neuen Technologie: Wir sehen anfangs nur die Möglichkeiten. Die Security ist immer die After-Show.

Chancen auf eine gerechtere WeltWie die Regeln im Detail aussehen werden, ist noch nicht abzusehen. Auch nicht, ob und inwiefern sie die Wettbewerbsfähigkeit betroffener Unternehmen schmälern könnten. Klar ist: Langfristig kann KI nur durch internationale Abkommen reguliert werden. Schließlich wird auch in anderen Teilen der Welt die Technologie weiterentwickelt – vor allem in Asien.

Dort stehen den Bedenkenträgern aus der westlichen Welt Millionen, wenn nicht Milliarden Menschen wie Vijayalakshmi aus dem indischen Bangalore gegenüber. Sie verdient als Köchin 100 Dollar im Monat, spricht kein Englisch und nutzt nur die nötigsten Funktionen ihres Handys. Trotzdem hat sie kürzlich mit KI-Technologie experimentiert. Sie stellte einem Bot in ihrer Muttersprache Kannada Fragen zu Bildungsstipendien für ihren 15jährigen Sohn, der Bot antwortete Augenblicke später mit einer menschlichen Stimme. Normalerweise hätte sie, um an diese Informationen zu kommen, Mittelsmänner teuer bezahlen müssen.

Die KI, die ihr geholfen hat, übersetzt mehrere der mehr als 100 lokalen Sprachen in Indien. Sie wurde von OpenNyAI entwickelt. Die indische NGO hat sich explizit der Förderung der Gerechtigkeit durch künstliche Intelligenz verschrieben – und liegt damit auf Regierungslinie. Während in den westlichen Industrieländern an Regulierungen gearbeitet wird, blickt man in Indien vor allem auf die Chancen: Künstliche Intelligenz gilt als ein Werkzeug, mit dem Sprachbarrieren abgebaut, mehr Bildung verbreitet und kulturelle Unterschiede überwunden werden können. Dazu passt, was Microsoft-CEO Natya Nadella – ein gebürtiger Inder – auf dem World Economic Forum 2023 sagte: „Wir warten immer noch darauf, dass in großen Teilen der Welt nach 250 Jahren die industrielle Revolution endlich ankommt.“ Er glaubt daran, dass KI diesen Nachholbedarf stillen könnte. Und steht mit diesem Glauben nicht allein.

Fast unbemerkt hat sich zwischen reichen und armen Ländern ein KI-Kulturkampf entwickelt: zwischen denjenigen, die viel zu verlieren haben – und den anderen. Es ist ein Disput, der vor allem in der Praxis, in Projekten und Anwendungen, ausgetragen wird. Denn im Gegensatz zu klassischen Produktionsmitteln ist KI eine niedrigschwellige Technologie: Existiert erst mal die Infrastruktur, braucht es vor allem Ideen.

In ärmeren Ländern führte das zu sehr viel Aktivität in kurzer Zeit. Unternehmen und NGOs dort haben zahlreiche vorbildliche Projekte auf den Weg gebracht. Ein paar Beispiele:

Ushahidi (Kenia): Die Open-Source-Plattform sammelt Daten in Krisensituationen – und zwar nicht nur von Response-Teams, sondern auch von den Menschen vor Ort, etwa per SMS und aus sozialen Medien – und visualisiert sie. So bekommen die Einsatzteams mehr und schneller Informationen.

Wadhwani AI (Indien): Die in neun Sprachen erhältliche App hilft mit Bilderkennung, Datenanalyse und maschinellem Lernen beispielsweise Millionen kleinen Baumwollfarmern in Indien, Schädlingsbefall zu erkennen, zu interpretieren und den passenden Zeitpunkt für die Bekämpfung zu finden.

Farmerline (Ghana): Die Plattform nutzt KI, um Landwirten per Handy Informationen wie Wettervorhersagen, Marktpreise und Anbauwissen in lokalen Sprachen bereitzustellen. Insbesondere in Gebieten, in denen der Zugang zum Internet begrenzt und die Alphabetisierungsrate niedrig ist.

Selbstverständlich gibt es solche Entwicklungen auch in der westlichen Welt, zum Beispiel im Bildungsbereich: Beim Bildungsservice Cognii fördern virtuelle Assistenten Studentinnen und Studenten im direkten Austausch per Chatbot. Die nicht kommerzielle Online-Lernplattform Khan Academy macht Lerninhalte individualisiert zugänglich. Eine Revolution in der Bildung, deren Folgen kaum überschätzt werden können.

Vom extrem niedrigschwelligen Zugang profitieren aber auch Kriminelle. Cybercrime wie Sabotage, Erpressung oder Datendiebstahl waren früher aufwendige Verbrechen für sehr spezialisierte Gruppen. Mit der neuen Technologie werden sie für jeden durchführbar. Wer bislang dachte, sein Unternehmen sei zu klein, unwichtig oder unbekannt, um das Ziel von Cyberattacken zu werden, lebte schon immer gefährlich. Inzwischen ist es wie ein Spaziergang mitten auf der Autobahn. Nachts. Und nun? Was kann man tun?

〉Einige Antworten hat Marc Stoecklin, der in Zürich das Security Research Department von IBM Research Europe leitet. Er kennt die Gefahren von künstlicher Intelligenz sehr gut, aber auch die Lösungswege. Stoecklin ist nämlich für die Entwicklung künstlicher Intelligenz für Cybersecurity verantwortlich, insbesondere im Bereich automatisierter Sicherheitssysteme, deren Prinzip ist: erkennen, untersuchen, reagieren.

Der Sicherheitsentwickler

Marc Stoecklin leitet das Security Research Department von IBM Research Europe in Zürich. Er ist seit 2006 für IBM tätig, war im IBM T. J. Watson Research Center und im Industry & Cloud Solutions Department tätig, hat IBMs COVID-19 Technology Taskforce geleitet und beschäftigt sich heute mit dem Einsatz von KI für Cybersecurity.

Herr Stoecklin, wir hören ständig, dass uns künstliche Intelligenz extrem voranbringen wird, aber zugleich hören wir, dass sie enorm gefährlich ist. In welchem Verhältnis stehen die Chancen und Gefahren wirklich?

Marc Stoecklin: Ich fürchte, es gibt darauf keine klare Antwort. Die Chancen sind tatsächlich sehr, sehr groß, um sehr viele gute Dinge zu tun. Doch künstliche Intelligenz ist auch eine Technologie mit Schwächen, die ausgetrickst oder für Böses genutzt werden kann. Das ist bei jeder Technologie so: Anfangs sehen wir vor allem die Möglichkeiten – die Security ist immer die After-Show.

Nehmen Sie ein konkretes aktuelles Problem: Phishing. Mails, mit denen versucht wird, Daten wie etwa Passwörter abzugreifen, können heute mit KI-Technologie wahnsinnig präzise, persönlich, dynamisch und zugleich vollautomatisch generiert werden. Andererseits kann KI-Technologie Menschen auch dabei unterstützen, sich vor solchen Mails zu schützen. Das ist eine Art Duell, ein Rennen.

Und wie wird es enden?

Das ist nicht absehbar. Was auch schon in der Technologie begründet ist. Das lässt sich gut an Generative Adversarial Networks (GANs) zeigen, also Systemen, in denen zwei künstliche Intelligenzen unüberwacht voneinander lernen. Sie können zum Beispiel eine KI, die Deep Fakes generiert, mit einer anderen KI verbinden, die Deep Fakes erkennt. Beide KI werden durch das Feedback der jeweils anderen KI besser, sodass sich die beiden im Zusammenspiel mit der Zeit hochkochen. Und dabei ist nicht vorhersehbar, wohin das Ganze am Ende führt.

Wenn die Technologie eskaliert, wird der Mensch irgendwann nicht mehr mitkommen. Führt das zwangsläufig zu einem Technologie-Wettlauf?

Ich fürchte schon. Ich gebe Ihnen ein anderes Beispiel: Schularbeiten. Wie lange wird ein Mensch noch unterscheiden können, ob etwas von einem Kind oder einer Maschine geschrieben wurde? Da muss irgendwann Technologie her. Und es muss auch regulatorisch eingegriffen werden. Damit werden wir uns auseinandersetzen müssen.

Wo stehen wir zurzeit im Wettlauf zwischen KI, die uns hilft, und KI, die uns bedroht? Wer liegt vorn?

Es gibt gerade sehr viel spannende universitäre Forschung, aber auch sehr gute Deep Fakes – Sie kennen sicherlich den Papst im Balenciaga-Outfit. Grundsätzlich ist es so, dass diejenigen, die solche Fälschungen erschaffen, gedanklich immer einen Schritt voraus sind.

Sie arbeiten an Detektionssystemen, die Fälschungen automatisch erkennen – wie gut sind die heute?

Die Trefferquote ist sehr gut, die Herausforderung ist die Fehlalarmquote. Der Empfänger sollte nicht mit zu vielen Fehlern überlastet werden, weil er dann das Tool nicht mehr nutzt und es irrelevant wird. Die Frage ist: Wie schaffe ich ein System, das den Benutzer nicht ermüdet?

Die Frage ist auch: Wie schnell wird es so etwas geben?

Momentan ist die Entwicklung sehr schnell, das geht alles ruckzuck. Aber irgendwann wird es zu einem Gleichstand kommen, das ist wie bei jedem Wettrüsten. Es kommt zu einer Plattform-Immunisierung, die die Arbeit für beide Seiten schwierig macht, bis eine neue Technologie kommt – das ist dann der nächste Schauplatz.

Der Sicherheitsbewerter

Matthias Neu ist Referent im Referat „Bewertungsverfahren für eID-Technologien in der Digitalisierung“ im Bundesamt für Sicherheit in der Informationstechnik.

Für Marc Stoecklin, den Entwickler künstlicher Intelligenz, führt der eskalierende Wettlauf von hilfreichen und bedrohlichen KI-Systemen also zwangsläufig zu immer neuen Gefahren und Schutzmaßnahmen – und somit Produkten.

〉Matthias Neu hat eine andere Sicht. Der Spezialist für Deep Fakes beim Bundesamt für Sicherheit in der Informationstechnik (BSI) richtet seinen Blick vor allem auf die Menschen und erklärt, warum:

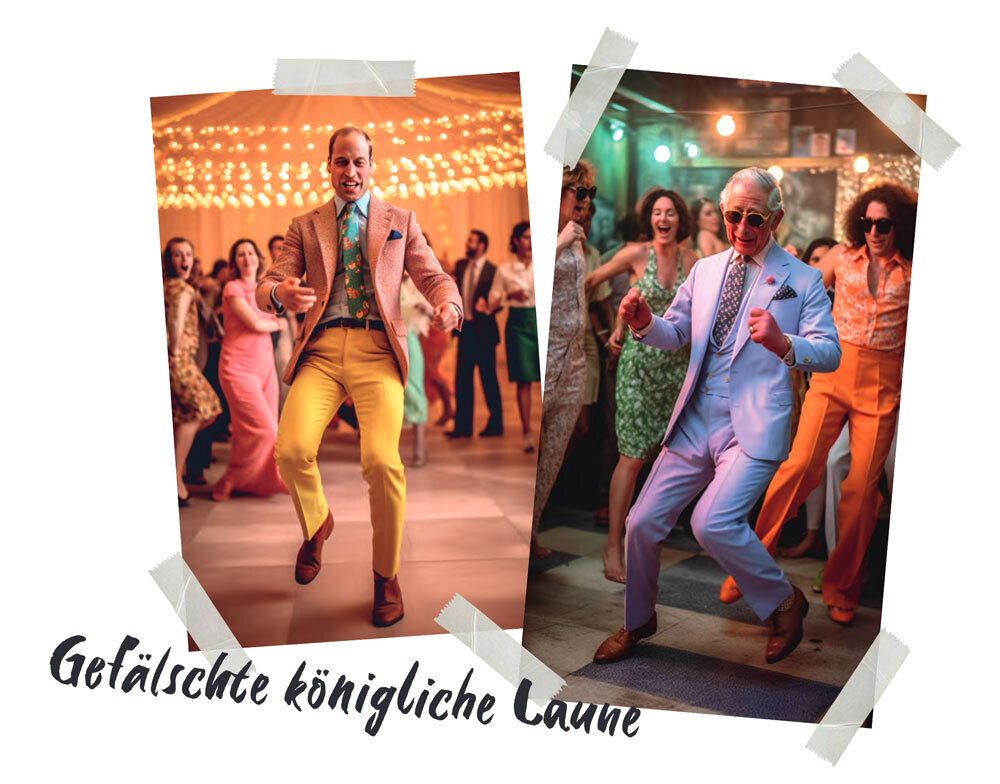

„Es gibt bei Deep Fakes drei große Bereiche: Audio Deep Fakes, Video und Bild Deep Fakes sowie textbasierte Fakes. Der Begriff entstand vor fünf, sechs Jahren. Damals funktionierten die Fälschungen mehr schlecht als recht, doch seitdem gab es eine enorme Entwicklung sowohl in der Qualität der Fälschungen als auch in der Zugänglichkeit der nötigen Werkzeuge.

Seit Anfang 2023 existiert zum Beispiel ein cloudbasierter Dienst, mit dem auch Laien sehr einfach Text in Sprache verwandeln können – mit jeder beliebigen Stimme. Früher wurden etwa 20 Stunden Audiomaterial von der Zielperson benötigt, um eine Fälschung zu erstellen. Bei dem neuen Dienst lädt man eine Minute Audiomaterial der Person hoch, zahlt ein paar Euro und kann danach jeden Text mit deren Stimme beziehungsweise einer sehr ähnlichen Stimme sprechen lassen.

Das gibt es mittlerweile auch als Voice Conversion, bei der Texte nicht geschrieben, sondern gesprochen werden. Sie sprechen live, und Ihre Stimme wird mit einer winzigen Verzögerung in eine andere Stimme konvertiert. Für dieses Verfahren werden aktuell noch mehr Expertise und Ressourcen benötigt, aber es ist nur eine Frage der Zeit, bis das als Dienst angeboten wird. Das wird für Angriffe auf Unternehmen und Organisationen in Zukunft auf jeden Fall relevant werden.

Verhindern lassen sich solche Fälschungen nicht – die Systeme gibt es nun mal. Schutz bietet vor allem die Sensibilisierung der Mitarbeiterinnen und Mitarbeiter. Die müssen wissen, dass die Technik existiert und dass deshalb bei einem Anruf die Stimme einer Person als Authentizitätsmerkmal nicht mehr ausreicht. Schon gar nicht, wenn es um wichtige Entscheidungen wie etwa eine Geldtransaktion geht. Die Unternehmen müssen einen Prozess gestalten, der sicherstellt, dass dafür ein Anruf nicht genügt. Es könnte zum Beispiel die Regel geben, dass die Person außerdem eine signierte E-Mail schicken muss. Oder dass jemand die Person unter der Nummer zurückrufen muss, die auch sonst im Alltag genutzt wird.

Die Bedrohungsszenarien von Videofakes sehen anders aus. Es ist beispielsweise vorstellbar, dass jemand einer Videokonferenz mit dem Gesicht einer bekannten Person beitritt, mit deren Stimme spricht und dann sensible Informationen mithört. Es könnten auch gefälschte kompromittierende Bilder der Chefin veröffentlicht werden, etwa vor dem Börsengang. So etwas kann sehr großen Schaden anrichten. Und auch das lässt sich nicht verhindern.

Aber es gibt die Möglichkeit, präventiv zu arbeiten: also vorher ankündigen, was vom Unternehmen ins Internet gestellt wird, und alles Offizielle grundsätzlich kryptografisch signieren, sodass es nachverfolgt werden kann. Damit ist zumindest klar, was wirklich aus dem Unternehmen kommt und was nicht den offiziellen Prozess durchlaufen hat.

Und dann sind da auch noch die Textgeneratoren, Large Language Models wie ChatGPT, die für große Phishing-Angriffe genutzt werden können, um beispielsweise an Passwörter zu kommen. Damit lassen sich Nachrichten in Massen verschicken, die sehr stark personalisiert werden können, wenn man ihnen zum Beispiel die Social-Media-Profile der Zielpersonen als Zusatzinformationen gibt. E-Mails, die so erstellt werden, klingen sehr echt.

Phishing gibt es schon lange, aber inzwischen ist der Aufwand für Angreifer sehr niedrig, zumal nicht nur die E-Mails automatisiert werden können, sondern die Modelle auch interaktiv agieren: Wenn eine Person zurückschreibt, bekommt sie automatisch eine Reaktion. So lassen sich große, qualitativ hochwertige Angriffe ausführen, bei denen Hunderte Mitarbeiterinnen und Mitarbeiter angeschrieben werden können. Das lässt sich nicht verhindern. Auch dafür müssen Unternehmen ihre Beschäftigten sensibilisieren und neue Prozesse installieren. In Zukunft wären automatisierte Detektionsverfahren ideal,

wahrscheinlich auf der Basis künstlicher Intelligenz, mit denen sich klassifizieren ließe: Ist das Material echt oder nicht? Daran wird aktuell geforscht. Zum Glück, weil solche Angriffe künftig sicher noch besser und leichter möglich werden.

Aber die Sensibilisierung ist ebenso wichtig, vor allem wenn wir über Desinformation sprechen. Es ist essenziell, zu verstehen, dass ein Foto oder ein Film kein Beweis dafür ist, dass etwas wirklich so geschehen ist, wie es aussieht. Wir müssen als Gesellschaft lernen, Bilder zu hinterfragen, denn es gibt noch keine zuverlässigen technischen Möglichkeiten, sich vor solchen Fakes zu schützen.“

Das alles ist nur der Anfang. Künstliche Intelligenz wird in den kommenden Jahren immer besser und billiger werden – und damit zumindest kurzfristig gefährlicher. Sie hat damit aber auch das Potenzial, die Welt deutlich zu verbessern. Welche Seite am Ende die Oberhand haben wird, ist nicht absehbar. Nur eines ist sicher: Die Zukunft war schon lange nicht mehr so offen wie heute.

Dieser Text stammt aus unserer Redaktion Corporate Publishing.